SAS SAN mit iSCSI SAN ersetzen

Hallo zusammen,

vor mir steht eine Herausforderung und zwar muss ich ein alte SAN (IBM Storwize) mit einen neuen ersetzen (Synology SA3200D). Alte SAN ist über SAS an zwei Failovercluster angebunden. Der neue läuft über iSCSI.

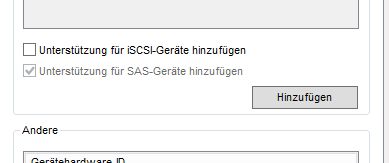

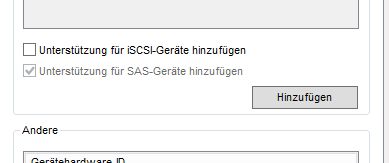

Mein Frage dazu ist, wie ich es am geschickten machen kann, um die Daten von den IBM SAN auf dem Synology zu übertragen und gleichzeitig die Einstellungen von dem Failovercluster so anzupassen, dass es alles reibungslos funktioniert. Hier meine ich die MPIO Einstellungen. Ich habe versucht bei eine VM die Einstellungen so vorzubereiten wie ich es an dem Cluster machen wollte, also die Unterstützung gleichzeitig für iSCSI und SAN Geräte erlauben, dort bekam ich aber ein BSOD.

Vielleicht hat jemand schon das gleiches oder ähnliches Thema hinter sich und konnte mir behilflich sein.

Eine Anleitung, wie ich ein rein iSCSI SAN anbinden kann habe ich schon im Internet gefunden:

https://www.hyper-v-server.de/whitepaper/installation-und-konfiguration- ...

Vielen Dank für eure Hilfe oder Ratschläge

Lubos

vor mir steht eine Herausforderung und zwar muss ich ein alte SAN (IBM Storwize) mit einen neuen ersetzen (Synology SA3200D). Alte SAN ist über SAS an zwei Failovercluster angebunden. Der neue läuft über iSCSI.

Mein Frage dazu ist, wie ich es am geschickten machen kann, um die Daten von den IBM SAN auf dem Synology zu übertragen und gleichzeitig die Einstellungen von dem Failovercluster so anzupassen, dass es alles reibungslos funktioniert. Hier meine ich die MPIO Einstellungen. Ich habe versucht bei eine VM die Einstellungen so vorzubereiten wie ich es an dem Cluster machen wollte, also die Unterstützung gleichzeitig für iSCSI und SAN Geräte erlauben, dort bekam ich aber ein BSOD.

Vielleicht hat jemand schon das gleiches oder ähnliches Thema hinter sich und konnte mir behilflich sein.

Eine Anleitung, wie ich ein rein iSCSI SAN anbinden kann habe ich schon im Internet gefunden:

https://www.hyper-v-server.de/whitepaper/installation-und-konfiguration- ...

Vielen Dank für eure Hilfe oder Ratschläge

Lubos

Please also mark the comments that contributed to the solution of the article

Content-Key: 922136658

Url: https://administrator.de/contentid/922136658

Printed on: May 3, 2024 at 20:05 o'clock

16 Comments

Latest comment

Sers,

kommt drauf an wie die Platten der VMs angebunden sind. Verwendest du VHDX die auf einem vom Storwize gehosteten CSV liegen?

Wenn ja ist es einfach: Du migrierst mit Hyper-V Manager oder PowerShell einfach auf die neue CSV, das auf der Synology gehostet wird.

Das neue CSV solltest du mit NTFS formatieren. ReFS macht hier noch diverse Probleme. Verwende ReFS Volumes bitte nur dann als CSV wenn du eine direkte Anwendung aus den ReFS-eigenen Funktionen hast.

Die Anleitung Hyper-V Storage Live Migration: VHDX im laufenden Betrieb verschieben für Hyper-V Server 2012 hat weiterhin bestand.

Wenn du dich an die Anleitung hälst sollte es soweit passen.

Hast du für iSCSI eigene physikalische Netzwerkkarten vorgesehen, oder gibt es eine Doppelnutzung?

Grüße,

Philip

kommt drauf an wie die Platten der VMs angebunden sind. Verwendest du VHDX die auf einem vom Storwize gehosteten CSV liegen?

Wenn ja ist es einfach: Du migrierst mit Hyper-V Manager oder PowerShell einfach auf die neue CSV, das auf der Synology gehostet wird.

Das neue CSV solltest du mit NTFS formatieren. ReFS macht hier noch diverse Probleme. Verwende ReFS Volumes bitte nur dann als CSV wenn du eine direkte Anwendung aus den ReFS-eigenen Funktionen hast.

Die Anleitung Hyper-V Storage Live Migration: VHDX im laufenden Betrieb verschieben für Hyper-V Server 2012 hat weiterhin bestand.

Wenn du dich an die Anleitung hälst sollte es soweit passen.

Hast du für iSCSI eigene physikalische Netzwerkkarten vorgesehen, oder gibt es eine Doppelnutzung?

Grüße,

Philip

Moin LubosNovy,

als erstes ein paar Worte zu deiner Überschrift

Das ist so nicht ganz korrekt. Das IBM Storwize ist sehr wohl ein ausgewachsenes SAN, die SYNOLOGY ist jedoch ein NAS und nicht wirklich ein SAN. 😉

Rein technisch absolut kein Problem, rein Performancetechnisch hast du dir damit wahrscheinlich jedoch leicht ins Knie geschossen.

Zwei Failovercluster 🤔 du meinst sicherlich zwei Hyper-V Nodes die gemeinsam als Failovercluster laufen oder hast du wirklich zwei Hyper-V Failovercluster?

By the Way, die Datenübertragung über SAS erzeugt auf dem Host bei weitem keine so hohe CPU-Last wie die über iSCSI. 😉

Wie schon gesagt, grundsätzlich kein Problem, falls alles richtig verkabelt und auch konfiguriert ist.

Dein SYNO NAS hat zwei Controller und von Haus aus sind diese mit 1x10G und 2x1G NIC’s ausgestattet.

Jeder der SYNO Controller MUSS eine Verbindung zu jedem Node haben.

Die 1G NIC‘s willst du glaube ich nicht wirklich für iSCSI benutzen, somit steht dir eigentlich nur noch ein 10G Port pro Controller zur Verfügung. Der 10G Port des Controllers A und auch des Controllers B müssen nun über einen 10G Switch an alle Hyper-V Nodes weiterverteilt werden.

Du hast hoffentlich nicht einfach nur den 10G Port des Kontrollers A der SYNO mit dem Hyper-V-Node-1 verbunden und den 10G Port des Kontrollers B der SYNO mit dem zweiten Hyper-Node.

Wenn ja, das funktioniert so nicht.

Kannst du bitte ein paar mehr Details zu deiner Umgebung posten.

Aus wie viele Hyper-V Nodes besteht dein Failovercluster?

Hat deine SYNO nur die Standard NIC Ports (2x1G & 1x10G) oder hast du in dieser noch OptinCards mit evtl. weiteren 10G Ports verbaut?

Wie viele NIC’s hast du pro Hyper-V Node und wie sind diese aktuell konfiguriert?

Beste Grüsse aus BaWü

Alex

als erstes ein paar Worte zu deiner Überschrift

SAS SAN mit iSCSI SAN ersetzen

Das ist so nicht ganz korrekt. Das IBM Storwize ist sehr wohl ein ausgewachsenes SAN, die SYNOLOGY ist jedoch ein NAS und nicht wirklich ein SAN. 😉

vor mir steht eine Herausforderung und zwar muss ich ein alte SAN (IBM Storwize) mit einen neuen ersetzen (Synology SA3200D).

Rein technisch absolut kein Problem, rein Performancetechnisch hast du dir damit wahrscheinlich jedoch leicht ins Knie geschossen.

Alte SAN ist über SAS an zwei Failovercluster angebunden. Der neue läuft über iSCSI.

Zwei Failovercluster 🤔 du meinst sicherlich zwei Hyper-V Nodes die gemeinsam als Failovercluster laufen oder hast du wirklich zwei Hyper-V Failovercluster?

By the Way, die Datenübertragung über SAS erzeugt auf dem Host bei weitem keine so hohe CPU-Last wie die über iSCSI. 😉

Mein Frage dazu ist, wie ich es am geschickten machen kann, um die Daten von den IBM SAN auf dem Synology zu übertragen und gleichzeitig die Einstellungen von dem Failovercluster so anzupassen, dass es alles reibungslos funktioniert. Hier meine ich die MPIO Einstellungen. Ich habe versucht bei eine VM die Einstellungen so vorzubereiten wie ich es an dem Cluster machen wollte, also die Unterstützung gleichzeitig für iSCSI und SAN Geräte erlauben, dort bekam ich aber ein BSOD.

Wie schon gesagt, grundsätzlich kein Problem, falls alles richtig verkabelt und auch konfiguriert ist.

Dein SYNO NAS hat zwei Controller und von Haus aus sind diese mit 1x10G und 2x1G NIC’s ausgestattet.

Jeder der SYNO Controller MUSS eine Verbindung zu jedem Node haben.

Die 1G NIC‘s willst du glaube ich nicht wirklich für iSCSI benutzen, somit steht dir eigentlich nur noch ein 10G Port pro Controller zur Verfügung. Der 10G Port des Controllers A und auch des Controllers B müssen nun über einen 10G Switch an alle Hyper-V Nodes weiterverteilt werden.

Du hast hoffentlich nicht einfach nur den 10G Port des Kontrollers A der SYNO mit dem Hyper-V-Node-1 verbunden und den 10G Port des Kontrollers B der SYNO mit dem zweiten Hyper-Node.

Wenn ja, das funktioniert so nicht.

Vielleicht hat jemand schon das gleiches oder ähnliches Thema hinter sich und konnte mir behilflich sein.

Nicht nur einmal 🙃, zwar nicht auf eine SYNO, aber das macht unter dem Strich auch keinen grossen Unterschied.Kannst du bitte ein paar mehr Details zu deiner Umgebung posten.

Aus wie viele Hyper-V Nodes besteht dein Failovercluster?

Hat deine SYNO nur die Standard NIC Ports (2x1G & 1x10G) oder hast du in dieser noch OptinCards mit evtl. weiteren 10G Ports verbaut?

Wie viele NIC’s hast du pro Hyper-V Node und wie sind diese aktuell konfiguriert?

Beste Grüsse aus BaWü

Alex

Moin Philip,

😮 👍👍👍 😍

REFS ist in diesem Anwendungsfall definitiv zum 🤢🤮

Beste Grüsse aus BaWü

Alex

Das neue CSV solltest du mit NTFS formatieren. ReFS macht hier noch diverse Probleme.

😮 👍👍👍 😍

REFS ist in diesem Anwendungsfall definitiv zum 🤢🤮

Beste Grüsse aus BaWü

Alex

Zitat von @LubosNovy:

Hast du für iSCSI eigene physikalische Netzwerkkarten vorgesehen, oder gibt es eine Doppelnutzung?

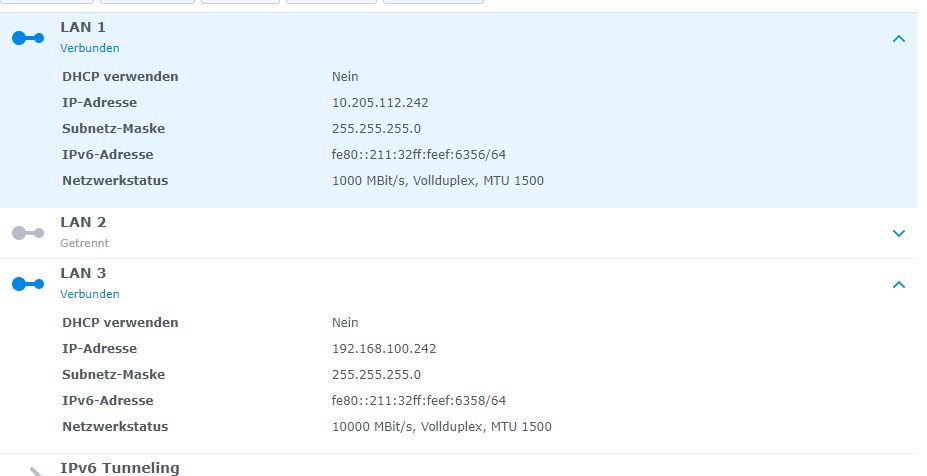

Es ist schon Netzwerk mit 10G NIC vorbereitet , der SYNO ist auch durch die 10G Karten mit einem 10G Switch verbunden.Das klingt doch schon ganz gut. Eine zusätzliche 10G NIC je Controller wäre besser in der Synology.

Haben die Server eigene NICs für iSCSI? Optimal wären bei deiner Konstellation 2 10G Ports je Server.

Moin LubosNovy,

das hört sich doch alles schon mal gar nicht so schlecht an.

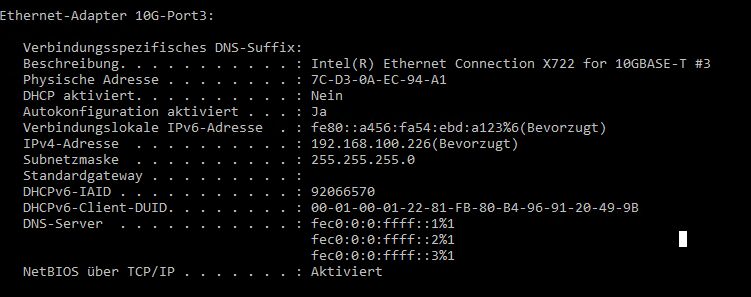

Wie sieht die IP Konfiguration der iSCSI Schnittstellen auf der SYNO aus und wie sind NIC's auf den beiden Hyper-V Nodes konfiguriert, über die der iSCSI Verkehr laufen soll.

Die Infos von "ipconfig /all" würden schon mal etwas weiterhelfen um ein besseres Bild deiner Lage zu bekommen.

Gruss Alex

das hört sich doch alles schon mal gar nicht so schlecht an.

Wie sieht die IP Konfiguration der iSCSI Schnittstellen auf der SYNO aus und wie sind NIC's auf den beiden Hyper-V Nodes konfiguriert, über die der iSCSI Verkehr laufen soll.

Die Infos von "ipconfig /all" würden schon mal etwas weiterhelfen um ein besseres Bild deiner Lage zu bekommen.

Gruss Alex

Zitat von @LubosNovy:

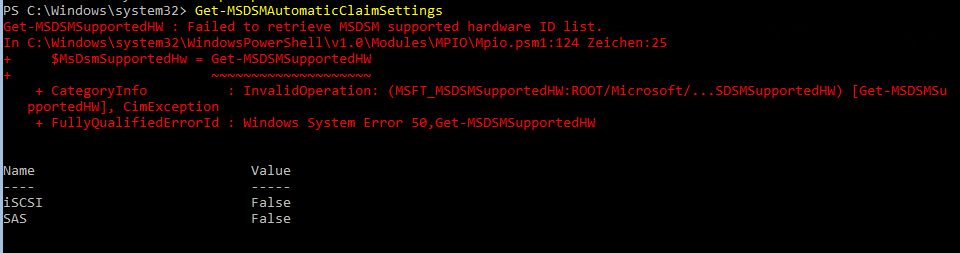

Um es zu erklären: Ich habe das Häkchen bei beim iSCSI Unterstützung gesetzt (siehe Originalpost) aber nicht bestätigt. Habe alles wieder zurückgestellt aber trotzdem bleibt die Fehlermeldung.

Ich denke dass ich bei der Umstellung aus SYNO auf dem Node1 die MPIO Feature neu installieren muss. Im Internet habe ich leider keine Anleitung/Hilfe gefunden.

Grüß

Lubos

Ich denke dass ich bei der Umstellung aus SYNO auf dem Node1 die MPIO Feature neu installieren muss. Im Internet habe ich leider keine Anleitung/Hilfe gefunden.

Grüß

Lubos

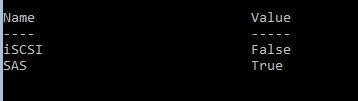

Du musst lediglich das Häkchen bei add Support for iScsi setzen und auf hinzufügen klicken, Host neu starten, fertig.

Wenn du unter MPIO Devices den MSFT200iSCSIBusType_0x9 gelistet hast, sollte die Verbindung funktionieren.

Danach trägst du im iScsi Initiator alle IPs der Synology SAN Adapter ein. Somit solltest du alle eingerichteten iScsi Targets sehen und kannst eine Verbindung herstellen. Sinnigerweise eine Session pro Host IP zu jeder von der NIC erreichbaren Storage IP, natürlich mit aktivierter Enable Multipath Option.

Moin Lubos,

Bitte auf den iSCSI relevanten NIC's IPv6 deaktivieren.

Ansonsten sieht das eigentlich ganz gut aus.

aber nicht bestätigt das war wahrscheinlich auch der Fehler.

rzlbrnft hat ja schon geschrieben wie du als nächstes vorgehen solltest.

https://www.youtube.com/watch?v=Bmf4cGZm0eo

So ab 9:20 siehts du was du bei deinen Nodes zu machen hast.

(Habe leider auf die schnelle keine bessere gefunden. 🙃)

Beste Grüsse aus BaWü

Alex

Bitte auf den iSCSI relevanten NIC's IPv6 deaktivieren.

Ansonsten sieht das eigentlich ganz gut aus.

Was mir aber zurzeit sorgen macht, ist das hier:

Um es zu erklären: Ich habe das Häkchen bei beim iSCSI Unterstützung gesetzt (siehe Originalpost) aber nicht bestätigt. Habe alles wieder zurückgestellt aber trotzdem bleibt die Fehlermeldung.

Um es zu erklären: Ich habe das Häkchen bei beim iSCSI Unterstützung gesetzt (siehe Originalpost) aber nicht bestätigt. Habe alles wieder zurückgestellt aber trotzdem bleibt die Fehlermeldung.

aber nicht bestätigt das war wahrscheinlich auch der Fehler.

rzlbrnft hat ja schon geschrieben wie du als nächstes vorgehen solltest.

Ich denke dass ich bei der Umstellung aus SYNO auf dem Node1 die MPIO Feature neu installieren muss. Im Internet habe ich leider keine Anleitung/Hilfe gefunden.

https://www.youtube.com/watch?v=Bmf4cGZm0eo

So ab 9:20 siehts du was du bei deinen Nodes zu machen hast.

(Habe leider auf die schnelle keine bessere gefunden. 🙃)

Beste Grüsse aus BaWü

Alex

Zitat von @LubosNovy:

Wie ich auch @rzlbrnft gefragt habe, wie sieht es aus wenn beides aktiviert ist? Also support für iSCSI und SAS in MPIO.

Wie ich auch @rzlbrnft gefragt habe, wie sieht es aus wenn beides aktiviert ist? Also support für iSCSI und SAS in MPIO.

Hab ich zwar noch nicht gemacht, aber im Prinzip installierst du dadurch nur zwei Microsoft eigene Treiber auf der Maschine.

Wenn das nicht konform sein sollte dürfte es ja nicht die Option dazu geben, oder jemand hat einen Fehler beim implementieren gemacht.

Hatte ich vor ein paar Jahren auf ner 2012r2 Plattform im Einsatz. Der Cluster lief 3 Jahre lang stabil als HyperV-FOC mit FS & SOFS Rollen als "Nebentätigkeit".

SAS MPIO für Clustered Storage Spaces mit SAS JBODs

iSCSI MPIO für ein QNAP NAS als Backup Repo im anderen Brandabschnitt