Umstellung zu 10 Gbit - Coreswitch?

Guten Tag,

wir bekommen demnächst eine neue Terminalserver Farm und müssen in diesem Zuge die Netzwerkverdrahtung ausbauen.

In unseren Schränken stehen 11 ESX Träger (IBM X3850 X5, HP ProLiant DL380 Gen8) als Basis für WTS (Provisioningserver, Lizenzserver, Fileserver, Terminalserver, ...), ein Firewallcluster und noch ein wenig Kleinkrams (Backup, Domino-Cluster).

Das SAN ist selbstverständlich separat angebunden und wird von einer Änderung des Management bzw. "Nutzdaten"-Netzes nicht tangiert.

Die 10 GBit werden hauptsächlich beim Starten eines Terminalservers für das PXE-Boot benötigt. Also für Managementzwecke im Hintergrund.

Nun stellt sich für uns die Frage, ob wir "normale" 1-2 HE Switche verwenden sollen oder ob es sich bei dieser Größenordnung schon lohnen würde auf einen Coreswitch umzusatteln.

Aktuell verwenden wir Switche von Juniper und Avaya. Würdet ihr die Hersteller auch im 10 GBit Bereich empfehlen?

Nachtrag:

Eben ist hier noch die Frage aufgenommen, ob man nicht auch 10GBASE-T nutzen könne. Ich bin der Ansicht, dass da evtl. schon an fehlenden NICs scheitern könnte. Sehe ich das richtig?

wir bekommen demnächst eine neue Terminalserver Farm und müssen in diesem Zuge die Netzwerkverdrahtung ausbauen.

In unseren Schränken stehen 11 ESX Träger (IBM X3850 X5, HP ProLiant DL380 Gen8) als Basis für WTS (Provisioningserver, Lizenzserver, Fileserver, Terminalserver, ...), ein Firewallcluster und noch ein wenig Kleinkrams (Backup, Domino-Cluster).

Das SAN ist selbstverständlich separat angebunden und wird von einer Änderung des Management bzw. "Nutzdaten"-Netzes nicht tangiert.

Die 10 GBit werden hauptsächlich beim Starten eines Terminalservers für das PXE-Boot benötigt. Also für Managementzwecke im Hintergrund.

Nun stellt sich für uns die Frage, ob wir "normale" 1-2 HE Switche verwenden sollen oder ob es sich bei dieser Größenordnung schon lohnen würde auf einen Coreswitch umzusatteln.

Aktuell verwenden wir Switche von Juniper und Avaya. Würdet ihr die Hersteller auch im 10 GBit Bereich empfehlen?

Nachtrag:

Eben ist hier noch die Frage aufgenommen, ob man nicht auch 10GBASE-T nutzen könne. Ich bin der Ansicht, dass da evtl. schon an fehlenden NICs scheitern könnte. Sehe ich das richtig?

Please also mark the comments that contributed to the solution of the article

Content-Key: 234193

Url: https://administrator.de/contentid/234193

Printed on: April 19, 2024 at 09:04 o'clock

8 Comments

Latest comment

Hi Penicillin,

Mit deiner kurzen Beschreibung ohne die Anzahl der Geräte, Mitarbeiter und Ausßenstellen zu nennen, kann es echt keine Empfehlung geben, als viel tut gut.

10Gig ist ja jetzt nicht "state of the art". Das kommt schon in relativ normalen Switchen vor.

Und vor einer Änderung muss man erst einmal Nutzergewohnheiten, den IST-Zustand dokumentieren. Sonst bist du hinterher genau so schlau wie vorher. Da gibt es Leute, die behaupten es wäre langsam und du kannst nicht argumentieren oder gar prüfen.

Und wenn es dich interessiert. 10 Gig geht ganz normal über Kupfer (Cat6a) und 100m.

Wenn du Multimode Glasfaser hast, ist das mit den Entfernungen schon deutlich problematischer.

Gruß

Netman

Mit deiner kurzen Beschreibung ohne die Anzahl der Geräte, Mitarbeiter und Ausßenstellen zu nennen, kann es echt keine Empfehlung geben, als viel tut gut.

10Gig ist ja jetzt nicht "state of the art". Das kommt schon in relativ normalen Switchen vor.

Und vor einer Änderung muss man erst einmal Nutzergewohnheiten, den IST-Zustand dokumentieren. Sonst bist du hinterher genau so schlau wie vorher. Da gibt es Leute, die behaupten es wäre langsam und du kannst nicht argumentieren oder gar prüfen.

Und wenn es dich interessiert. 10 Gig geht ganz normal über Kupfer (Cat6a) und 100m.

Wenn du Multimode Glasfaser hast, ist das mit den Entfernungen schon deutlich problematischer.

Gruß

Netman

Ich habe vor kurzem noch mehrere "48-Port Summit X670 10G BaseT" von ExtremeNetworks für ein Projekt beschaffen lassen.

Das ist m.E. aktuell das Brot und Butter Produkt für Top of Rack und kleine Core. Das ist genau dein Ding. Hol Dir da ein paar von, entsprechenden Stack daraus bauen oder eine als Mittelstück im Stern (auf einen Stack als Dein 'Core') mit Mehrfachverbindungs-LAGs.

Es ist auch aktuell eine gute Zeit um zu 10G zu wechseln, da jeder Hersteller Standardmodelle hat. Ich rate in diesem Fall mal lieber von Juniper, Avaya, Nortel, HP, Dell-Powerconnect ab weil das die gleiche Hardware-Basis ist, nur die Software und der Support sind schlechter.

Du glaubst hoffentlich nicht, dass Juniper selber eine 10G 60-Port Backplane entwickelt hat. Das sind bei allen Herstellern die gleichen Teile mit 256G Stacking Links usw...

Das sind bei allen Herstellern die gleichen Teile mit 256G Stacking Links usw...

Das ist m.E. aktuell das Brot und Butter Produkt für Top of Rack und kleine Core. Das ist genau dein Ding. Hol Dir da ein paar von, entsprechenden Stack daraus bauen oder eine als Mittelstück im Stern (auf einen Stack als Dein 'Core') mit Mehrfachverbindungs-LAGs.

Es ist auch aktuell eine gute Zeit um zu 10G zu wechseln, da jeder Hersteller Standardmodelle hat. Ich rate in diesem Fall mal lieber von Juniper, Avaya, Nortel, HP, Dell-Powerconnect ab weil das die gleiche Hardware-Basis ist, nur die Software und der Support sind schlechter.

Du glaubst hoffentlich nicht, dass Juniper selber eine 10G 60-Port Backplane entwickelt hat.

Und wenn er nun gar kein 10G Base T hat sondern nit SFPPs und Twinax Kabeln arbeitet...?

Aber egal für diese Popelanforderung ist es vollkommen egal was für Hersteöler du verwendest wenn du nur simpel Layer 2 machst.

Es macht ja absolut keinen Sinn in einer Juniper und Avaya Umgebung nun auch noch einen dritten Hersteller dazuzunehmen !

Wenn dir das Latte ist dann sieh nach was Extreme, Cisco oder Brocade haben und such dir den schönsten und billigsten aus. Das sind alles Premium Hersteller wo du nichts falsch machst.

Wenns ums Geld geht und weniger um Qualität und Funktion dann gibts auch bei D-Link, HP und NetGear entsprechendes für 10G

Aber egal für diese Popelanforderung ist es vollkommen egal was für Hersteöler du verwendest wenn du nur simpel Layer 2 machst.

Es macht ja absolut keinen Sinn in einer Juniper und Avaya Umgebung nun auch noch einen dritten Hersteller dazuzunehmen !

Wenn dir das Latte ist dann sieh nach was Extreme, Cisco oder Brocade haben und such dir den schönsten und billigsten aus. Das sind alles Premium Hersteller wo du nichts falsch machst.

Wenns ums Geld geht und weniger um Qualität und Funktion dann gibts auch bei D-Link, HP und NetGear entsprechendes für 10G

Es muss nicht immer Glas sein !

Im Nahbereich bis zu 10 Meter ist es erheblich wirtschaftlicher man verwendet sog. "Twinax Direct Attach Copper (DAC) Kabel"

Das sind Twinax Kabel mit direkt angeschlossenem SFPP Stecker.

http://www.thomas-krenn.com/de/wiki/10_Gigabit_Ethernet

So ein Kabel ist erheblich billiger und kostet weniger als ein optisches GBIC für 10 Gig.

Wie gesagt nur bis 10 Meter. Wenn du Längen darüber hast dann musst du wieder Glas nehmen wenn du SFPP Stecker in den Endgeräten bzw. Switch hast.

Werden die Server hingegen mit 10g Base T (10 GiG über Cat 7 Kabel) geliefert benötigst du eh einen 10 Gig Switch der 10G Base T supportet.

Das geht dann wie 10/100/1000 Mbit Ethernet auch bis max. 100 Meter.

Thema Coreswitch:

Nein das lohnt sich bei deinem Popelnetz mit den paar Switches sicher nicht wenn es einen Bezug zur physischen Größe haben soll.

Allerdings verschwimmen da auch die Grenzen. 10 GiG Switches sind bei fast allen Herstellern stackbar und können meist auch Layer 3 Switching. Da hat man auf einer 1 HE "Pizzabox" auch einen "Coreswitch" wenn du so willst und das auch bei einem Mininetz.

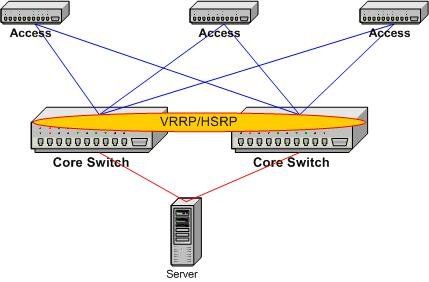

Core ist weniger eine Frage der Größe eines Switches sondern der Position im Netzwerk Design WO er eingesetzt wird für WAS.

Klassische Netzwerk Designs sehen so aus:

Da kann der Coreswitch der meist ein L3 Switch ist auch eine kleine Pizzabox sein. Bei mehreren Servern segmentiert man ja meist immer in VLANs um die L2 Broadcast Domains nicht zu groß werden zu lassen und so die Performance zu halten. Break Even ist so bei ca. 150 Clients in einer L2 Broadcast Domain. Verantwortungsvolle netzwerker trennen immer auch Server und Client Bereich auch bei mittelgroßen Netzen mit Ausfallredundanz. Kommt eben auf das Gesamtdesign an.

Im Nahbereich bis zu 10 Meter ist es erheblich wirtschaftlicher man verwendet sog. "Twinax Direct Attach Copper (DAC) Kabel"

Das sind Twinax Kabel mit direkt angeschlossenem SFPP Stecker.

http://www.thomas-krenn.com/de/wiki/10_Gigabit_Ethernet

So ein Kabel ist erheblich billiger und kostet weniger als ein optisches GBIC für 10 Gig.

Wie gesagt nur bis 10 Meter. Wenn du Längen darüber hast dann musst du wieder Glas nehmen wenn du SFPP Stecker in den Endgeräten bzw. Switch hast.

Werden die Server hingegen mit 10g Base T (10 GiG über Cat 7 Kabel) geliefert benötigst du eh einen 10 Gig Switch der 10G Base T supportet.

Das geht dann wie 10/100/1000 Mbit Ethernet auch bis max. 100 Meter.

Thema Coreswitch:

Nein das lohnt sich bei deinem Popelnetz mit den paar Switches sicher nicht wenn es einen Bezug zur physischen Größe haben soll.

Allerdings verschwimmen da auch die Grenzen. 10 GiG Switches sind bei fast allen Herstellern stackbar und können meist auch Layer 3 Switching. Da hat man auf einer 1 HE "Pizzabox" auch einen "Coreswitch" wenn du so willst und das auch bei einem Mininetz.

Core ist weniger eine Frage der Größe eines Switches sondern der Position im Netzwerk Design WO er eingesetzt wird für WAS.

Klassische Netzwerk Designs sehen so aus:

Da kann der Coreswitch der meist ein L3 Switch ist auch eine kleine Pizzabox sein. Bei mehreren Servern segmentiert man ja meist immer in VLANs um die L2 Broadcast Domains nicht zu groß werden zu lassen und so die Performance zu halten. Break Even ist so bei ca. 150 Clients in einer L2 Broadcast Domain. Verantwortungsvolle netzwerker trennen immer auch Server und Client Bereich auch bei mittelgroßen Netzen mit Ausfallredundanz. Kommt eben auf das Gesamtdesign an.

Ich kenne das Design eher so, dass eine Mittel-Switch mit Layer-2 Protokollen arbeitet und die Server dann an den Zugangsswitches. Wieso Switches über Routingprotokolle verbunden werden und dann die Server nicht an den Access-Geräten?

Das wäre dann in der Mitte ein Stack aus 2 Geräten der dann über LAG (LACP o.ä.), mit immer mindestens 2 Verbindungen mit je einer auf den unterschiedlichen Stack-Mitgliedern, auf die TOR-Switches oder Hauptserver geht.

Das wäre dann in der Mitte ein Stack aus 2 Geräten der dann über LAG (LACP o.ä.), mit immer mindestens 2 Verbindungen mit je einer auf den unterschiedlichen Stack-Mitgliedern, auf die TOR-Switches oder Hauptserver geht.

dass eine Mittel-Switch mit Layer-2 Protokollen arbeitet und die Server dann an den Zugangsswitches

Wenn man zw. den VLANs routen muss dann sollten die Cores schon L3 Switches sein.Was den Rest betrifft hast du recht. Das HA Szenario kann man entweder mit VRRP/HSRP machen wenn man keine Stacking Switches hat.

Bei Stacking Switches entfällt das natürlich, da der Stack Verbindungslink die Switches ja also logisch einen Switch erstellt.