Performance Messung mit IOMETER am Storage

Hallo Forum,

vielleicht kann mir jemand weiterhelfen?

Ich würde gern meine IOPS an dem SAN Storage mit dem IOMETER testen.

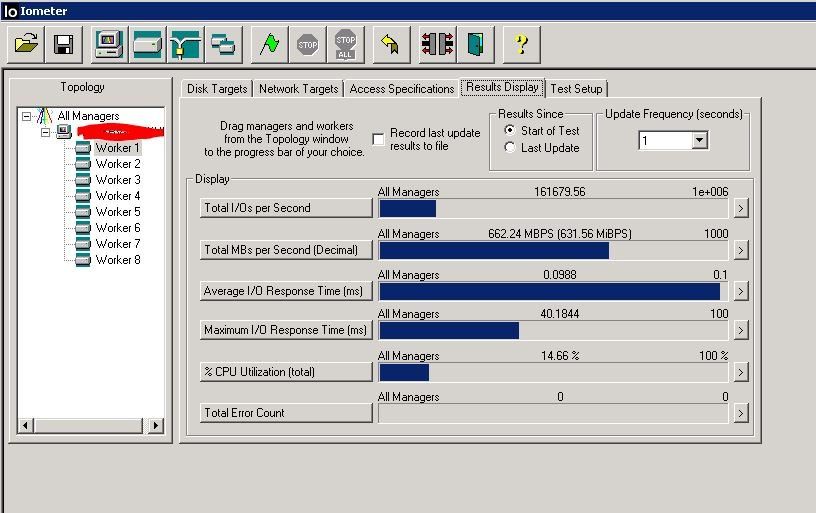

Folgende Werte habe ich eingestellt:

20000000 Sectors

Outstanding I/Os = 16

4KiB; 100% Read; /0% random

run time = 50 sec

Ramp time = 5

Die Werte habe ich mal angehängt, vielleicht kann mir jemand dazu etwas sagen?

Dahinter steht eine MSA mit testweise 5 x RAID 5 mit jeweils 8 Platten, das Ganze im 16G SAN

vielleicht kann mir jemand weiterhelfen?

Ich würde gern meine IOPS an dem SAN Storage mit dem IOMETER testen.

Folgende Werte habe ich eingestellt:

20000000 Sectors

Outstanding I/Os = 16

4KiB; 100% Read; /0% random

run time = 50 sec

Ramp time = 5

Die Werte habe ich mal angehängt, vielleicht kann mir jemand dazu etwas sagen?

Dahinter steht eine MSA mit testweise 5 x RAID 5 mit jeweils 8 Platten, das Ganze im 16G SAN

Please also mark the comments that contributed to the solution of the article

Content-Key: 348765

Url: https://administrator.de/contentid/348765

Printed on: April 26, 2024 at 18:04 o'clock

12 Comments

Latest comment

Sorry für die späte Antwort:

Das IOMeter ist "frei Konfigurierbar" um jede erdenkliche Lastsituation simulieren zu können.

Die Konfiguration in deinem ersten Post ist allerdings m.M. ein wenig "praxisfremd".

100% Lesende 4k Blöcke sind mir jedenfalls noch nie untergekommen.

Kein Wunder das deine MSA dann "Traumwerte" mit 1mS Latenz und 160.000 IOPS abgiebt.

(Tröste dich: Viele Werbeaussagen der Storage Hersteller werden genau so ermittelt!)

Dies beweist wie aussagekräftig "IOPS" Werte in der Produktwerbung sind!

Um einen aussagekräftigeren Wert zu bekommen, würde ich den vorgegebenen "All in One", welcher so ziemlich alle denkbaren Betriebssituationen umfasst, als Test empfehlen.

Wenn Du allerdings z.B. mit einer 100% VSphere Umgebung arbeitest, kannst du die vorgegebene Blocksize des VMFS (8k) vorgeben und das Schreib/Leseverhältnis aus der Monitoring Funktion der VSphere übernehmen (Zumeist ca. 70% Read)

Die Größe der Testdatei sollte in jedem Fall größer als der Cache der Controller sein (Bei der MSA 2040/42 = 16GB)

Für jeden geplanten Server würde ich einen "Worker" mit dieser Workload laufen lassen, oder auf jeden angeschlossenen Server einen eigenen "Dynamo" installieren.

6.000 IOPS halte ich übrigens bei einem reinen "10k SAS RAID5" und "linearen" LUN für einen realistischen Wert...

Bei der MSA kann man aber durch "Virtuelle" LUN die auf beide Controller (Pools) aufgeteilt werden bereits mess und spürbare Geschwindigkeitsvorteile erhalten.

Unsere MSA2042 habe ich so (Allerdings mit "All Flash") auf 27.000 IOPS bei 1mS Latenz (8k Random 50% Read, 8Gbit/s FC) "getrieben"

Diese "Best Practices" sollten die Grundlage der Konfiguration bilden:

https://www.hpe.com/h20195/v2/GetPDF.aspx/4AA4-6892ENW.pdf

Das IOMeter ist "frei Konfigurierbar" um jede erdenkliche Lastsituation simulieren zu können.

Die Konfiguration in deinem ersten Post ist allerdings m.M. ein wenig "praxisfremd".

100% Lesende 4k Blöcke sind mir jedenfalls noch nie untergekommen.

Kein Wunder das deine MSA dann "Traumwerte" mit 1mS Latenz und 160.000 IOPS abgiebt.

(Tröste dich: Viele Werbeaussagen der Storage Hersteller werden genau so ermittelt!)

Dies beweist wie aussagekräftig "IOPS" Werte in der Produktwerbung sind!

Um einen aussagekräftigeren Wert zu bekommen, würde ich den vorgegebenen "All in One", welcher so ziemlich alle denkbaren Betriebssituationen umfasst, als Test empfehlen.

Wenn Du allerdings z.B. mit einer 100% VSphere Umgebung arbeitest, kannst du die vorgegebene Blocksize des VMFS (8k) vorgeben und das Schreib/Leseverhältnis aus der Monitoring Funktion der VSphere übernehmen (Zumeist ca. 70% Read)

Die Größe der Testdatei sollte in jedem Fall größer als der Cache der Controller sein (Bei der MSA 2040/42 = 16GB)

Für jeden geplanten Server würde ich einen "Worker" mit dieser Workload laufen lassen, oder auf jeden angeschlossenen Server einen eigenen "Dynamo" installieren.

6.000 IOPS halte ich übrigens bei einem reinen "10k SAS RAID5" und "linearen" LUN für einen realistischen Wert...

Bei der MSA kann man aber durch "Virtuelle" LUN die auf beide Controller (Pools) aufgeteilt werden bereits mess und spürbare Geschwindigkeitsvorteile erhalten.

Unsere MSA2042 habe ich so (Allerdings mit "All Flash") auf 27.000 IOPS bei 1mS Latenz (8k Random 50% Read, 8Gbit/s FC) "getrieben"

Diese "Best Practices" sollten die Grundlage der Konfiguration bilden:

https://www.hpe.com/h20195/v2/GetPDF.aspx/4AA4-6892ENW.pdf

Outstanding I/Os = 16 / Dieser Wert ist mir aber etwas unklar

Die Outstanding I/Os" geben an wieviele I/O von den Workern GLEICHZEITIG erzeugt werden.

Je höher dieser Wert, desdo höher die Belastung, desdo höher die I/O Latenz und dadurch geringer die IOPS...

Ob 16 ein realstischer wert ist, muss man durch das Monitoring der bestehenden Umgebung selbst ermitteln.

Im Moment dürfte sich das System ähnlich wie ein ESXi Server mit etwa 15-20 "einfachen" VM verhalten.

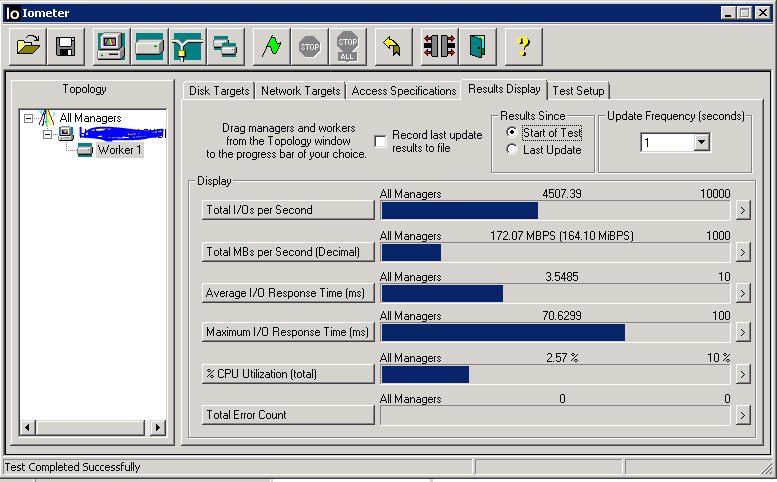

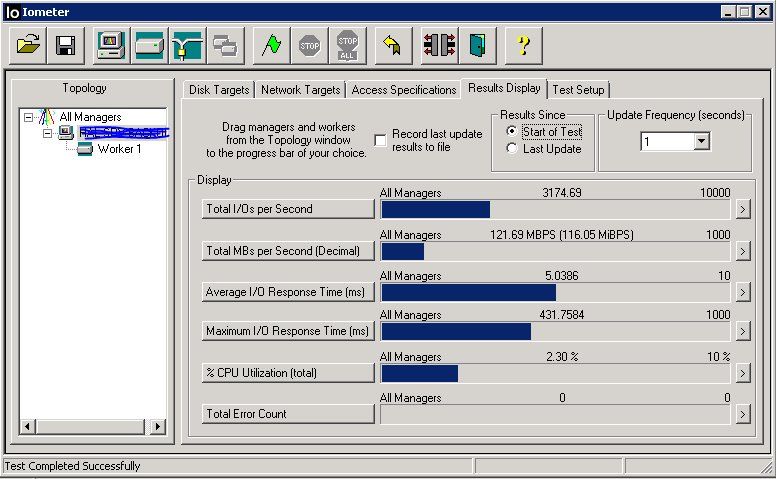

Das scheint dann ja ein fast ganz normaler Wert zu sein?

Erscheint mir, im Verhältnis zur RAID5(50?) Konfiguration etwas niedrig!

Das müsste noch schneller gehen. (Obwohhl 3,5mS ein sehr guter Wert in einer "All turning" Umgebung ist...)

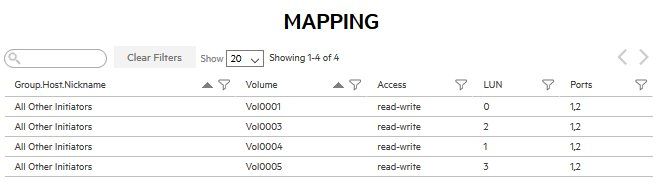

Wie sind die LUN auf die Pools (Controller) verteilt? (Mapping)

Ich vermute das der Testserver nur en einem einzigen Controller "gemapt" wurde?!

Pool A = 2 x Raid 10 mit jeweils 10 Platten

Warum hast du nicht alle 20 Platten in einen einzigen RAID10 Pool konfiguriert?

Hierdurch hast Du die maximal mögliche Leistung halbiert...

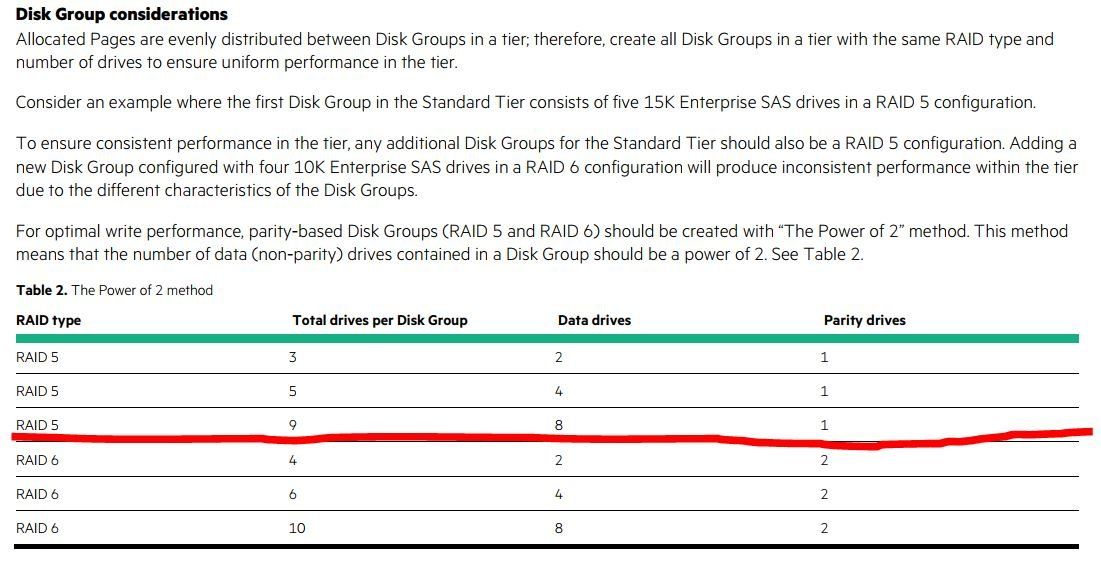

Pool B = 2 x Raid 5 mit jeweils 9 Platten

Auch hier:

Warum nicht ein RAID50 über alle Platten?

Und: Ungerade Anzahlen mögen Storages generell nicht!

Lieber 2x 8Platten, oder 2x 10 Platten in einem RAID50

Ich vermute das der Testserver nur en einem einzigen Controller "gemapt" wurde?!

Mpio ist konfiguriert.Dies allein reicht nicht unbedingt...

Das "Mapping" der aus den Pools erzeugten Volumes, sollte so angelegt sein, das beide Controller symetrisch über alle verfügbare FC Ports mit den beiden Ports im Host verbunden werden.

"Symetrie" ist das "A&O" jeder "Tuningmaßnahme" auf den MSA (und generell allen anderen 2-Controller-) Storages.

Pool A = 2 x Raid 10 mit jeweils 10 Platten

Hier gingen nur Max. 16 Platten. Was hätte ich dann mit den 4 Platten gemacht? So habe ich es aufgeteilt, wie du es hier im Forum irgendwann geschrieben hattest.

Hier gingen nur Max. 16 Platten. Was hätte ich dann mit den 4 Platten gemacht? So habe ich es aufgeteilt, wie du es hier im Forum irgendwann geschrieben hattest.

Sorry, dann habe ich Dich missverstanden.

Dann hast Du ein einziges RAID10 mit INSGESAMT 16 Platten?

Pool B = 2 x Raid 5 mit jeweils 9 Platten

Die Parity ist auf alle Platten im RAID5 verteilt, es gibt keine dedizierte Parity Platte wie bspw. bei RAID3!

Dies bedeutet, das die Gesamtzahl aller Platten im RAID eine gerade Anzahl aufweisen sollte.

"Ungerade" darf nur die HotSpare Platte sein, da diese nur "leer mitläuft" und nur im Fall des Ausfalles einer der Platten im RAID aktiviert wird und so die gerade Anzahl widerherstellt.

Es sind jeweils 2 FC Ports symmetrisch an den beiden FC Switchen. Der Server geht ebenso mit einem Port an Switch1 und mit dem 2. PORT an den Switch 2

"Physisch" hast Du vermutlich nichts falsch gemacht! Die "Verdrahtung" scheint okay...

Aber überprüfe das Mapping (Zuordung der Volumes zu den Ports und Servern) noch einmal.

Im Idealfall ist der Server mit jeweils einem Port auf einem der FC Switche, welche ihrerseits jeweils mit beiden Controllern verbunden sind.

(Also gehen von jedem Switch jeweils ein Kabel an den ersten und ein weiteres an den zweiten Controller)

Genau so sollten die einzelnen Volumes innerhalb des Storage gemappt werden. Jedem Volume sollten pro Controller 2 Ports (Also insgesamt 4) zugeordnet werden.

Aber nicht falsch verstehen:

Wir "tunen" hier bereits auf relativ "hohem Niveau"!

Die zu erreichenden Erfolge spielen sich pro Einzelmaßnahme im einstelligen Prozentbereich ab.

Erst die Beseitigung mehrere dieser "Bremsen" bewirkt eine spürbare Beschleunigung der Latenzen.

Nein, ich habe im POOL A 2 Disk Groups mit jeweils 10 Platten im RAID10

Jede Platte, die in einem RAID10, 5 oder 6 hinzugefügt wird, steigert die Performance des gesamten RAID Verbundes.

Daher würde ich empfehlen, hier nur ein RAID10 über 16 Platten zu konfigurieren.

Anschließend kannst Du den Speicherplatz durch Volumes (LUN) partitionieren.

Pool B = 2 x Raid 5 mit jeweils 9 Platten

Interessant!

Eigentlich habe ich dies einst von HPE anders vermittelt bekommen.

Allerdings stammt mein Wissen auch aus der Zeit der seligen MSA P2000 G2...

(Da gab es noch "Single Port SAS" Platten)

Möglicherweise hat HPE die Anforderungen der vierten und fünften MSA Generationen etwas gelockert, da HPE die alten Single Port Platten nicht mehr supportet(?)

Ich denke aber, das man das für und wieder einer geraden/ungeraden Anzahl von Platten in diesem Array nur durch Performance Messungen feststellen kann.

Die sind ja beim Mapping automatisch gewählt?

So sollte es sein!

Bei mir sieht es bspw. so aus: