SSD mit RAID 50

Hi,

in HP DL380 Servern passen Pro HDD Box 8 Festplatten hinein.

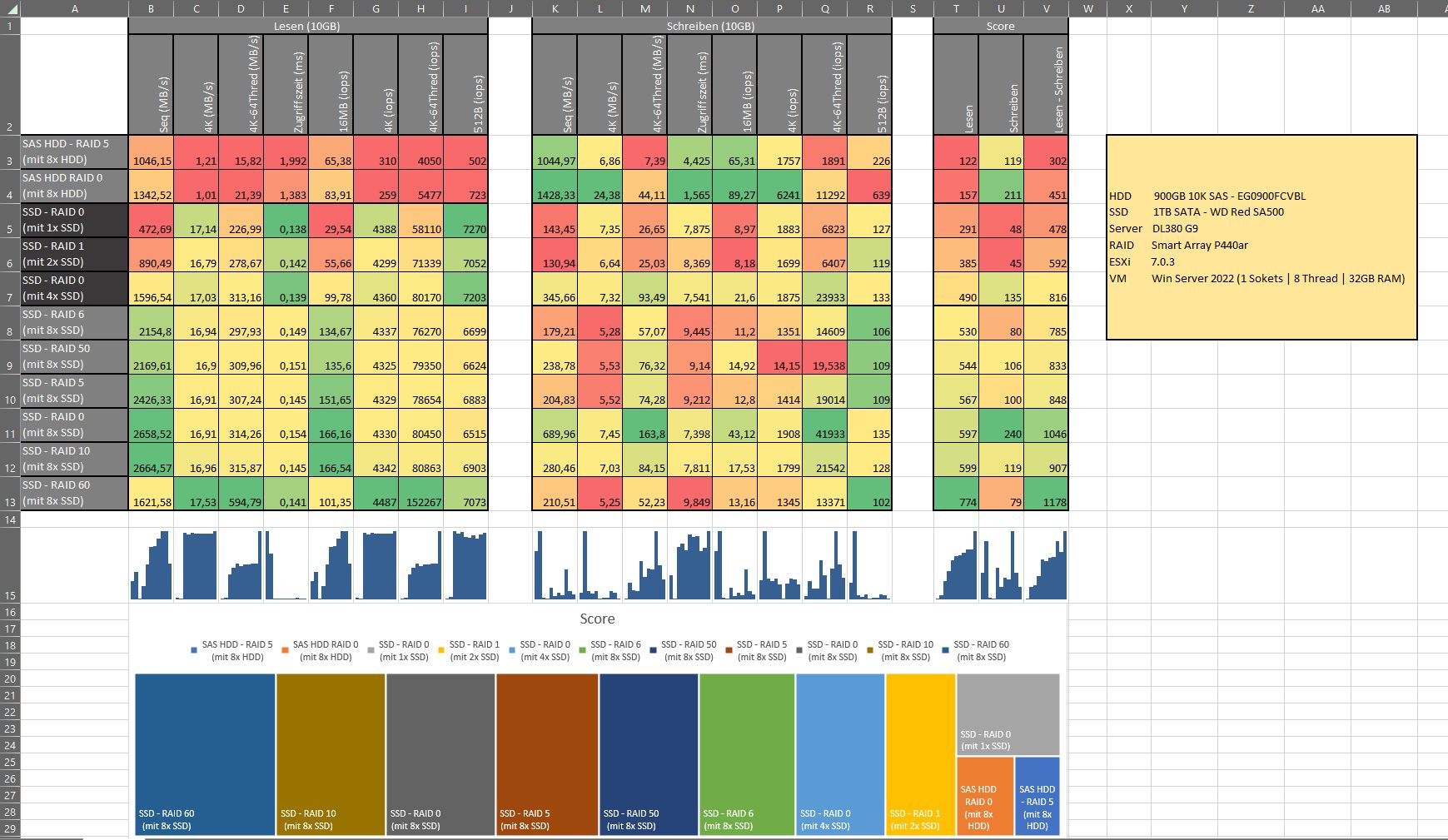

Jedes mal wieder stelle ich mir dabei die Frage welches RAID für z.B. 1TB SSDs wohl die bessere wahl ist.

Aktuell weiß ich das RAID1 eine gute Performance bietet.

Scheinbar ist RAID 5 nicht so richtig gut für SSDs, da dies die Lebensdauer einschränken soll, da die Paritätsschreiberrei die SDDs ermüdet.

Bei RAID 10 bekomme ich einen größeren Speicherpool und Kombiniere den vorteil aus Raid 0 und Raid 1.

Soviel ich gelesen habe, soll sich das auch nicht wirklich negativ auf die SSDs auswirken.

Aber wozu man kaum etwas findet ist zum Thema Raid 50.

Ja ich brauche 2 Platten für die Parität im gegensatz zu Raid 5, bekomme dafür aber:

- Eine höhere ausfallsicherheit im vergleich zu Raid 5

- Habe scheinbar etwa die gleiche Lesegeschwindigkeit wie bei Raid 5?

- Habe scheinbar eine höhere Schreibgeschwindigkeit als bei Raid 5?

- Und wie sieht es mit der Lebensdauer bei Raid 50 aus?

Vielen Dank für eure Ideen

in HP DL380 Servern passen Pro HDD Box 8 Festplatten hinein.

Jedes mal wieder stelle ich mir dabei die Frage welches RAID für z.B. 1TB SSDs wohl die bessere wahl ist.

Aktuell weiß ich das RAID1 eine gute Performance bietet.

Scheinbar ist RAID 5 nicht so richtig gut für SSDs, da dies die Lebensdauer einschränken soll, da die Paritätsschreiberrei die SDDs ermüdet.

Bei RAID 10 bekomme ich einen größeren Speicherpool und Kombiniere den vorteil aus Raid 0 und Raid 1.

Soviel ich gelesen habe, soll sich das auch nicht wirklich negativ auf die SSDs auswirken.

Aber wozu man kaum etwas findet ist zum Thema Raid 50.

Ja ich brauche 2 Platten für die Parität im gegensatz zu Raid 5, bekomme dafür aber:

- Eine höhere ausfallsicherheit im vergleich zu Raid 5

- Habe scheinbar etwa die gleiche Lesegeschwindigkeit wie bei Raid 5?

- Habe scheinbar eine höhere Schreibgeschwindigkeit als bei Raid 5?

- Und wie sieht es mit der Lebensdauer bei Raid 50 aus?

Vielen Dank für eure Ideen

Please also mark the comments that contributed to the solution of the article

Content-Key: 5501576095

Url: https://administrator.de/contentid/5501576095

Printed on: April 27, 2024 at 22:04 o'clock

24 Comments

Latest comment

Moin,

https://www.lacie.com/de/de/manuals/6big12bigtbolt3/raid/

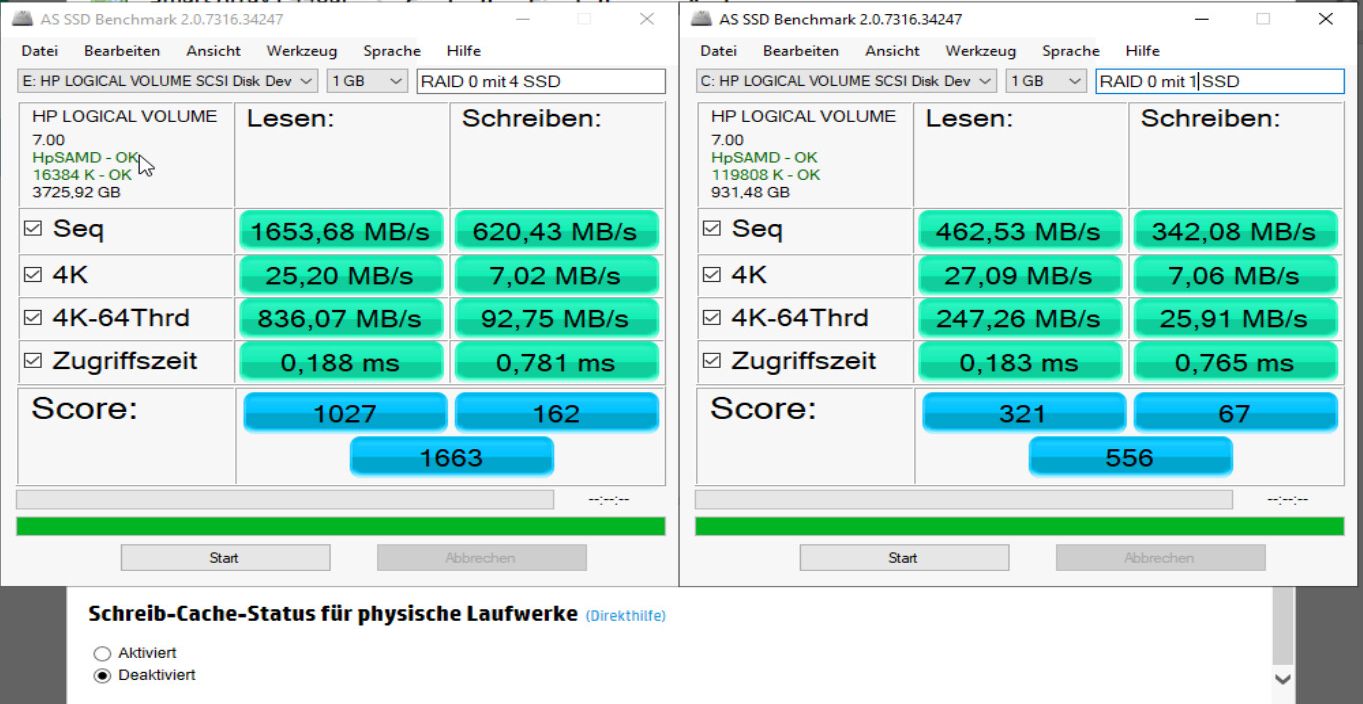

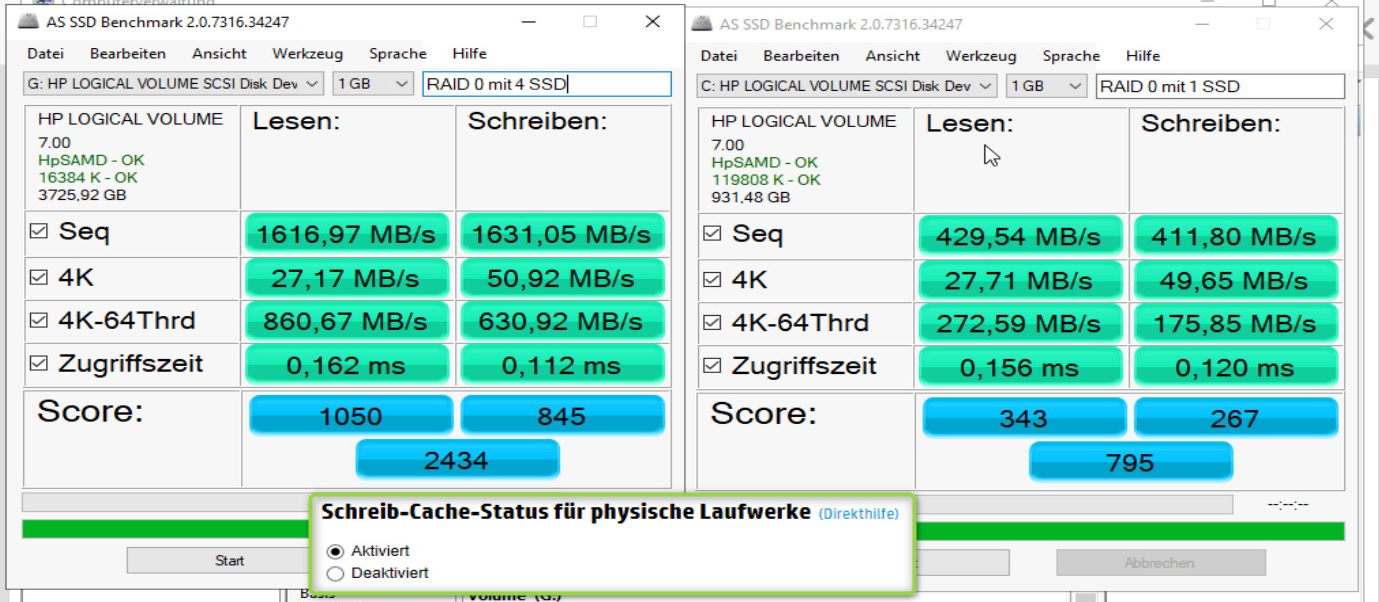

Und ja, die Lese-Geschwindigkeit steigt "enorm", da ja die Daten von zwei MEdien angeliefert werden. Fraglich nur, ob dein Databus/ Controller die Daten auch schnellgenug bereitstellen bzw. dein Zielsystem diese schnell genug verarbeiten kann...

Schreiben ist auch geringfügig schneller, da die Daten ja jeweils zur Hälfte auf zwei Medien parallel geschrieben werden.

RAID 50 im Zeitalter von SSDs/ NVMes sehe ich mal als recht selten an.

Was hast du überhaupt mit der Performance vor?

Also wie viele IOPS erwartest/ brauchst du?

Ja ich brauche 2 Platten für die Parität im gegensatz zu Raid 5, bekomme dafür aber:

Streng genommen ist es die Kapazität von 2 Medien, brauchst insgesamt also mindestens 6 Speichermedien:https://www.lacie.com/de/de/manuals/6big12bigtbolt3/raid/

Und ja, die Lese-Geschwindigkeit steigt "enorm", da ja die Daten von zwei MEdien angeliefert werden. Fraglich nur, ob dein Databus/ Controller die Daten auch schnellgenug bereitstellen bzw. dein Zielsystem diese schnell genug verarbeiten kann...

Schreiben ist auch geringfügig schneller, da die Daten ja jeweils zur Hälfte auf zwei Medien parallel geschrieben werden.

RAID 50 im Zeitalter von SSDs/ NVMes sehe ich mal als recht selten an.

Was hast du überhaupt mit der Performance vor?

Also wie viele IOPS erwartest/ brauchst du?

Mit RAID will man ja Ausfallsicherheit und Geschwindigkeit gegenüber einer Solo-Disk erreichen. Seid SSDs ist das aber alles noch mal neu zu überdenken. Und seit NVME ist das sogar wieder zu überdenken. Da reicht echt in den meisten Fällen ein Simples RAID-1 aus. Die Geschwindigkeit und Zugriffszeit ist derart irre, dass man sich komplizierte RAID-Konstellationen fast(!) schon sparen kann.

Darum jetzt die Frage von Interesse: Was hast du damit vor?

Darum jetzt die Frage von Interesse: Was hast du damit vor?

Morschen.

Außerdem sollte man beachten, dass sich die Lebenszeit der SSD durch die Paritätsbildung bei RAID 5(0) und 6(0) schneller verkürzt, als bei einem reinen Spiegel.

Ich würde hier @it-fraggle folgen und ein RAID 1 oder 10 bei mehr als zwei SSD konfigurieren.

Gruß

Marc

Außerdem sollte man beachten, dass sich die Lebenszeit der SSD durch die Paritätsbildung bei RAID 5(0) und 6(0) schneller verkürzt, als bei einem reinen Spiegel.

Ich würde hier @it-fraggle folgen und ein RAID 1 oder 10 bei mehr als zwei SSD konfigurieren.

Gruß

Marc

Das Problem mit der Abnutzung durch Parität dürfte auf RAID50 genauso zutreffen wie auf RAID5.

Es gibt bei manchen Anbietern von Controllern oder SAN propritäre Verfahren die die Paritätsblöcke z.B. auf alle Platten verteilen als gezielt eine Platte mit Parität zu beschreiben, eventuell würde das einen Unterschied machen. Ich kenne das von NetApp mit dynamic disk pool DDP.

Es gibt bei manchen Anbietern von Controllern oder SAN propritäre Verfahren die die Paritätsblöcke z.B. auf alle Platten verteilen als gezielt eine Platte mit Parität zu beschreiben, eventuell würde das einen Unterschied machen. Ich kenne das von NetApp mit dynamic disk pool DDP.

Zitat von @ukulele-7:

Das Problem mit der Abnutzung durch Parität dürfte auf RAID50 genauso zutreffen wie auf RAID5.

Es gibt bei manchen Anbietern von Controllern oder SAN propritäre Verfahren die die Paritätsblöcke z.B. auf alle Platten verteilen als gezielt eine Platte mit Parität zu beschreiben, eventuell würde das einen Unterschied machen. Ich kenne das von NetApp mit dynamic disk pool DDP.

Das Problem mit der Abnutzung durch Parität dürfte auf RAID50 genauso zutreffen wie auf RAID5.

Es gibt bei manchen Anbietern von Controllern oder SAN propritäre Verfahren die die Paritätsblöcke z.B. auf alle Platten verteilen als gezielt eine Platte mit Parität zu beschreiben, eventuell würde das einen Unterschied machen. Ich kenne das von NetApp mit dynamic disk pool DDP.

RAID 5 und 6 verteilen die Paritäten immer auf allen Platten. RAID 3 + 4 hingehen schreiben auf eine dedizierte Disk.

Was du ggf. meinst, ist ein Distributed RAID. Hierbei wird die HotSpare nicht auf einem einzelnen Drive "ausgelagert" sondern alle Platten im Verbund halten Speicherblöcke frei, die dann im Falle eines Ausfalls beschrieben werden. Das Rebuild ist so um einiges schneller.

Ich habe in meinen rund 20 Jahren in der IT nur ein einziges Mal RAID50 gesehen. Im Laufe der Jahre und verbesserter Technologie wurde mehr und mehr auf RAID10 verändert, zumindest im Bereich Storage. RAID10 hat sich fast überall durchgesetzt, da die Redundanz und Performance am besten ist bei kritischen Anwendungen und Daten.

Wir haben ausschließlich RAID10 im Einsatz auf den Servern und SAN. RAID5 bzw. 6 kommt nur für das Backup-System zum Einsatz.

Wir haben ausschließlich RAID10 im Einsatz auf den Servern und SAN. RAID5 bzw. 6 kommt nur für das Backup-System zum Einsatz.

Zitat von @em-pie:

RAID 5 und 6 verteilen die Paritäten immer auf allen Platten. RAID 3 + 4 hingehen schreiben auf eine dedizierte Disk.

Stimmt das hatte ich falsch im Kopf.Zitat von @ukulele-7:

Das Problem mit der Abnutzung durch Parität dürfte auf RAID50 genauso zutreffen wie auf RAID5.

Es gibt bei manchen Anbietern von Controllern oder SAN propritäre Verfahren die die Paritätsblöcke z.B. auf alle Platten verteilen als gezielt eine Platte mit Parität zu beschreiben, eventuell würde das einen Unterschied machen. Ich kenne das von NetApp mit dynamic disk pool DDP.

Das Problem mit der Abnutzung durch Parität dürfte auf RAID50 genauso zutreffen wie auf RAID5.

Es gibt bei manchen Anbietern von Controllern oder SAN propritäre Verfahren die die Paritätsblöcke z.B. auf alle Platten verteilen als gezielt eine Platte mit Parität zu beschreiben, eventuell würde das einen Unterschied machen. Ich kenne das von NetApp mit dynamic disk pool DDP.

RAID 5 und 6 verteilen die Paritäten immer auf allen Platten. RAID 3 + 4 hingehen schreiben auf eine dedizierte Disk.

Was du ggf. meinst, ist ein Distributed RAID. Hierbei wird die HotSpare nicht auf einem einzelnen Drive "ausgelagert" sondern alle Platten im Verbund halten Speicherblöcke frei, die dann im Falle eines Ausfalls beschrieben werden. Das Rebuild ist so um einiges schneller.

Mir ist allerdings auch nicht ganz klar warum ausgerechnet ein Paritätsblock die SSD mehr belastet als ein normaler Datenblock, wenn sich doch alles auf alle Datenträger gleichmäßig verteilt. Die Berechnung macht der Controller, der Block sollte keine anderen Eigenschaften haben als ein normaler Datenblock. Es fällt lediglich etwas mehr Speichervolumen an was zu etwas mehr Nutzung führt, oder wo sehe ich den Unterschied nicht?

Es ist unüblich, weil es ggü. RAID1(0) eine große Zahl von Datenträgern erfordert bzw. nur mit diesen wirtschaftliche Vorteile bietet. Gleichzeitig löst es aber die mit großen Volumes verbundenen Probleme nicht, da der Controller im Gegensatz zu RAID6 durch die einfache Parität kein Quorum zur Fehlerkorrektur gewinnt.

Also die bei RAID1(0) oder RAID5 aufgrund der Anwendungsfälle und begrenzten Kapazität meist nicht erforderliche und bei RAID6(0) schon anzuratende Integritätsprüfung auf Dateisystemebene wäre für ein RAID50 absolut erforderlich; und unter der Prämisse macht man heute kein Hardware-RAID mehr.

Grüße

Richard

Zitat von @testtomat:

... ohne Ausfälle im Einsatz:

zusätzlich zum RAID 1 Systembereich folgende Datenbereiche:

RAID 5 aus 5 x Samsung SSD PM883 seit 4 Jahren als Web- und DB-Server (hohe Last)

RAID 5 aus 4 x Samsung SSD SM863 seit 3,5 Jahren als Web- und DB-Server (geringe Last)

... ohne Ausfälle im Einsatz:

zusätzlich zum RAID 1 Systembereich folgende Datenbereiche:

RAID 5 aus 5 x Samsung SSD PM883 seit 4 Jahren als Web- und DB-Server (hohe Last)

RAID 5 aus 4 x Samsung SSD SM863 seit 3,5 Jahren als Web- und DB-Server (geringe Last)

An was für einem Controller und mit was für einem Durchsatz?

Bei beiden Arrays der Megaraid SAS 9271-8.

Beim PM883-Array kommen jeden Tag ca. 50-100 GB in Form von bis zu 100000 Dateien neu dazu ( Altdaten werden gelöscht ). Array ist zu 80% belegt. Die eigentliche Last entsteht dann aber erst durch die Verarbeitung der Dateien auf dem System. Durchsatz am Controller habe ich nicht parat. Dem gegenüber ist bei der PM883 TBW mit 1.4PB angegeben...

Beim PM883-Array kommen jeden Tag ca. 50-100 GB in Form von bis zu 100000 Dateien neu dazu ( Altdaten werden gelöscht ). Array ist zu 80% belegt. Die eigentliche Last entsteht dann aber erst durch die Verarbeitung der Dateien auf dem System. Durchsatz am Controller habe ich nicht parat. Dem gegenüber ist bei der PM883 TBW mit 1.4PB angegeben...